前言

已经时隔半年没有发阅读笔记的博客了,上一篇还是 https://haulyn5.cn/2020/02/06/paper-Som19/ 。

要读研究生的话就要天天接触 paper 了,还是应该多看一些积累一下视野,提高英语的读写能力。

这一篇依旧是 2019 S&P 上 Web 的paper。题目是 Measuring and Analyzing Search Engine Poisoning of Linguistic Collisions。

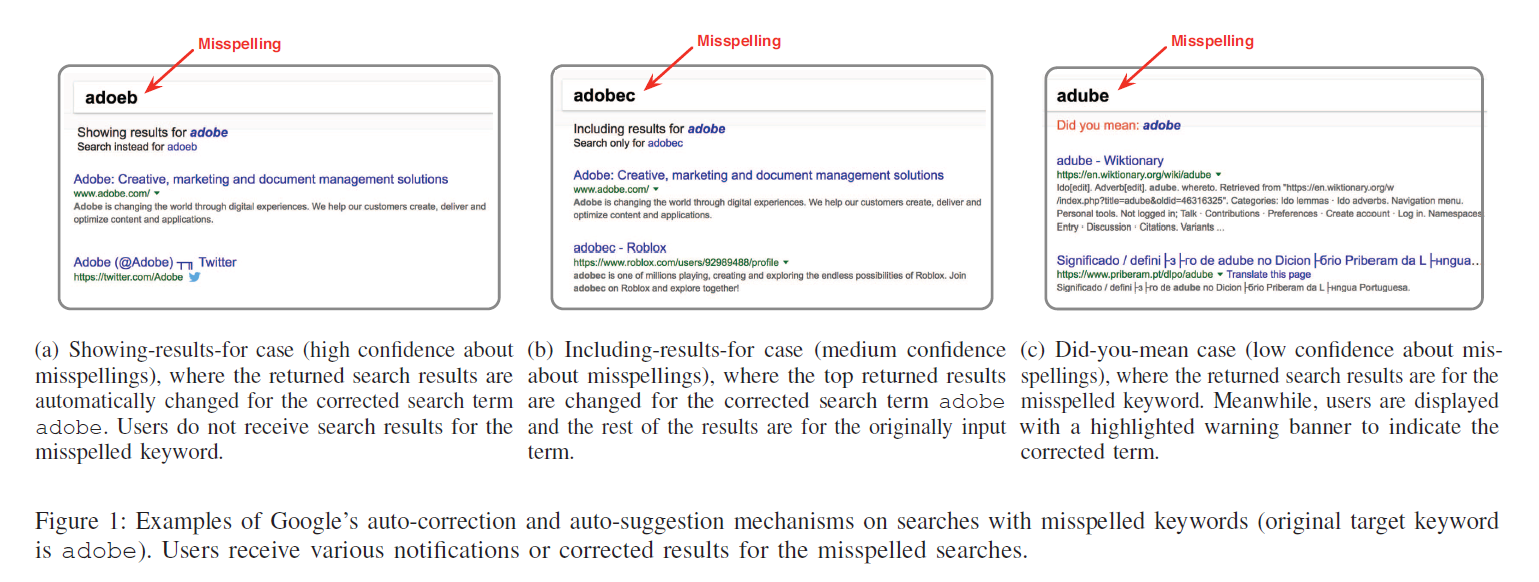

简单过了一下摘要、简介和部分的背景,感觉不大想继续往后看了,主题是做搜索引擎的Poisoning,通俗理解就是一些打错字的搜索关键词能让 Cybercriminals (原文使用的词,莫名的Cool) 得以利用,并且展示出非法的或者是假冒的网站。Google 和 Baidu 对于这种打错的关键词通常都会提醒用户,根据不同的 Confidence Level,会给出不同的 Auto Correction(这个我会在正文展开)。但是作者发现一种情况可以一定程度上绕开 Auto Correction: **Linguistic Collisions **。作者举的例子是:Adobe 可能被拼成 idobe,而这个单词并不是一个不合法单词,尽管英语没有这个单词,但是 idobe 是 Nigerian 语的掉下的意思。也就是说某个单词尽管错拼了,但是恰好又撞在其他语言的合法单词,这样搜索引擎就不会有较大的Confidence去认为用户拼错了,就会展示部分或全部的错拼单词的搜索结果(上例中就是 idobe 的搜索结果)。除此之外,作者用了 RNN 来提前预估某个单词有没有可能会被 Auto Correction,加速了研究进程。(万物都可深度学习)至于错拼单词的生成,作者利用了 edit distance operations and linguistic properties 。

正文

震惊 东西好像在前言说的差不多了。

初读的问题

这篇论文做了什么?做到什么程度?怎么做的?

作者发现了一种新的搜索引擎下毒方式 linguistic-collision,并且对中文和英文下的搜索、Google和百度进行了第一次大规模的 linguistic-collision search poisoning 研究。检查了 1.77 m 的错拼单词,发现了 1.19 %的没有Auto Correction的搜索结果中第一页中存在恶意网站。(相当大的数量了)。首先作者使用 edit distance operations and linguistic properties 来生成错拼单词,送入训练好的 RNN 来判断单词是否大概率被 Auto Correction。对于更可能不被 Correction 的单词,使用爬虫爬取结果,与黑名单对比判断是否存在恶意网站。

背景

这篇文章介绍了 Google 和 百度 的一个我经常使用但是总是忽略的机制: Auto Correction。

直接贴图了,图片来源 Measuring and Analyzing Search Engine Poisoning of Linguistic Collisions

有三种不同层级的 Auto Correction:

- 如果 high confidence,搜索引擎会直接显示他觉得正确的关键词的搜索结果,完全不显示用户输入的原始关键词的相关结果。

- medium confidence,搜索引擎会将他觉得正确的关键词与用户输入的关键词的搜索结果共同展示。

- low confidence,搜索引擎会显示用户输入关键词的搜索结果,但是给出他认为可能的正确关键词的 URL 供用户点击更改搜索关键词。

感受

这篇 paper 的题材不怎么吸引我,所以打算看到 background 就刷下一篇的(懒癌)。但是还是没忍住扫了一下后面的行文,感觉顶会 paper 还是强啊…… 图文并茂,各种图表和数据非常充分,重点内容的加粗高亮。就算不看内容都感觉好强……膜拜了

又水了一篇博客,边浪边看用了大约两三个小时?给下一篇留作参考了,不过这次连 background 都没刷完hhh